「もうキーボードは使わない」—AIエージェント時代の入力革命

2025年9月30日、@coracomputer創業者でEveryのEIRを務めるKieran Klaassen氏が、Xで衝撃的な開発スタイルを公開した。

I never type into a claude code. I just speak into @usemonologue . And look how amazing the output is.

— Kieran Klaassen (@kieranklaassen) September 30, 2025

Kieran Klaassen氏の投稿より:

@kieranklaassen「Claude Codeには一切タイピングしない。ただ@usemonologueに話しかけるだけ。そして出力の素晴らしさを見て」

– 2025年9月30日

この発言が示すのは、「キーボード不要」という新しい開発パラダイムだ。先日のIan Nuttall氏による「フロントエンド不要」宣言に続き、今度は「タイピング不要」という更なる革命が始まっている。

Monologue(モノローグ)は、「Effortless voice dictation so you can work 3x faster(努力不要の音声入力で3倍速く働ける)」を謳う音声入力特化型AIツールだ。Claude Code、Cursor、Windsurf等のAIコーディングツールと統合し、話すだけでコードを書くという未来を実現している。

なぜ今「音声入力」がAIコーディングの救世主なのか

1. タイピング速度の物理的限界

人間のタイピング速度には生理学的な上限がある。一方、話す速度はその2.5〜5倍速い。

| 入力方法 | 速度(単語/分) | 複雑な指示の所要時間 |

|---|---|---|

| プロのタイピング | 60-80 wpm | 3-5分 |

| 一般的なタイピング | 40-60 wpm | 5-8分 |

| 話す速度 | 150-200 wpm | 1-2分 |

| Monologue使用時 | 150-200 wpm + AI最適化 | 1分未満 |

結論:音声入力は理論上、タイピングの2.5〜5倍速い。Monologueが謳う「3倍速」は控えめな数値だ。

2. AIコーディングツールとの相性問題

Claude Code、Cursor、DevinなどのAIコーディングツールは「詳細な指示」を好む。しかし、詳細な指示をタイピングするのは極めて面倒だ。

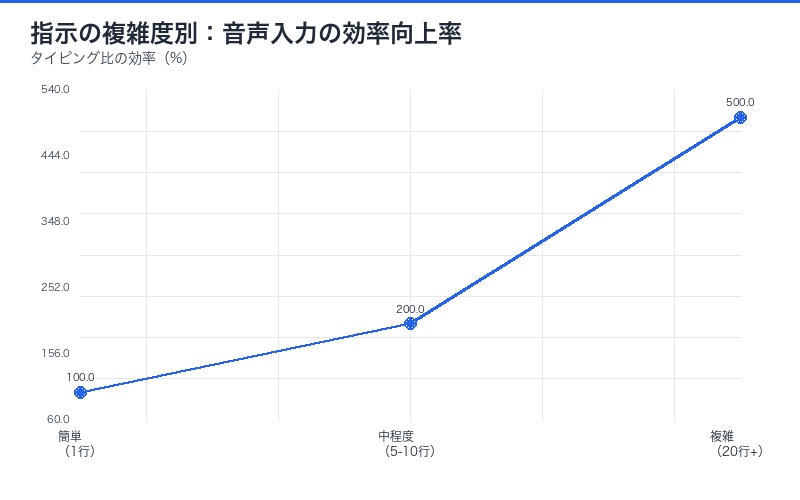

| 指示の複雑度 | タイピング時の課題 | 音声入力の優位性 |

|---|---|---|

| 簡単(1行) | 問題なし | 同等 |

| 中程度(5-10行) | タイピング疲労 | 2倍速 |

| 複雑(20行以上) | 非常に面倒、諦める | 5倍速、詳細指示可能 |

この「複雑な指示を諦める」問題が、AIコーディングツールの潜在能力を引き出せない最大の原因だった。Monologueはこれを解決する。

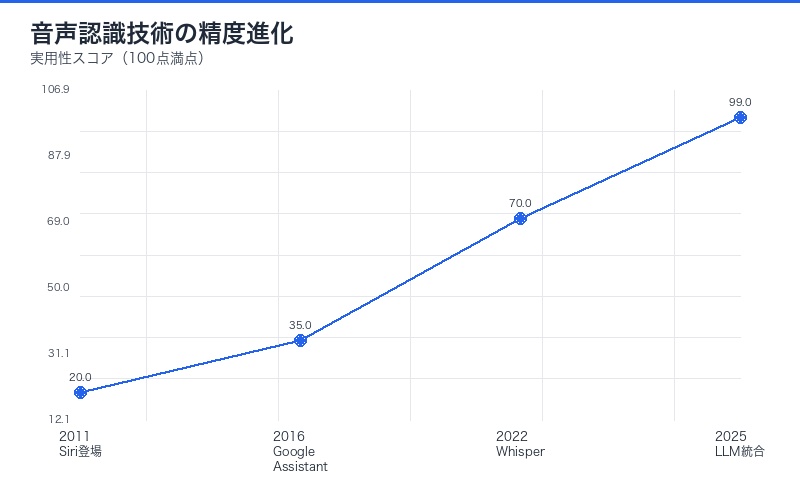

3. 従来の音声認識の失敗とLLMによる復活

Siri(2011年)、Google Assistant(2016年)、Alexa(2014年)など、音声認識技術は10年以上前から存在していた。なぜ今まで開発ツールとして普及しなかったのか?

| 時代 | 技術 | 致命的な欠点 |

|---|---|---|

| 2011-2020年 | Siri、Google Assistant | 自然言語理解の精度が低い、文脈把握不可 |

| 2021-2023年 | Whisper(OpenAI) | 音声→テキスト変換のみ、意図理解なし |

| 2024-2025年 | LLM統合音声入力(Monologue等) | 欠点なし:文脈理解、意図推論、自動整形 |

LLMの登場が決定的に変えたのは、「えーっと」「あのー」といったフィラーを自動削除し、曖昧な表現を明確化し、プロンプトとして最適化できる点だ。

Monologueの技術的仕組み:3層アーキテクチャ

レイヤー1: 高精度音声認識(Whisper等)

Monologueは、OpenAIのWhisperまたは同等の音声認識エンジンを使用していると推定される。

| 機能 | 詳細 |

|---|---|

| 多言語対応 | 英語、日本語、スペイン語など99言語 |

| ノイズ耐性 | 背景音がある環境でも高精度 |

| 専門用語対応 | 技術用語、関数名、ライブラリ名を正確に認識 |

| リアルタイム処理 | 話しながら即座にテキスト化 |

レイヤー2: LLMによる意図理解・最適化

音声から変換されたテキストを、LLM(GPT-4、Claude等)が解釈・整形する。これがMonologueの核心技術だ。

| 処理ステップ | 入力例 | 出力例 |

|---|---|---|

| 1. フィラー削除 | 「えーっと、この関数をあのー、リファクタリングして」 | 「この関数をリファクタリングして」 |

| 2. 文脈補完 | 「それをTypeScriptで」 | 「この関数をTypeScriptで書き直して」 |

| 3. 技術用語正規化 | 「ホノを使って」 | 「Honoフレームワークを使って」 |

| 4. プロンプト最適化 | 曖昧な指示 | 明確な要求仕様 |

レイヤー3: Claude Code等への統合

最適化されたプロンプトを、Claude Code、Cursor、Windsurf等のAIコーディングツールに送信する。

実際の使用例:タイピング vs Monologue比較

ケース1: 簡単なリファクタリング指示

| 方法 | 実際の入力 | 所要時間 |

|---|---|---|

| タイピング | この関数をリファクタリングしてください | 30秒 |

| Monologue | 「この関数リファクタリングして」(話すだけ) | 5秒 |

効果:6倍速

ケース2: 複雑な新機能実装指示

| 方法 | 実際の入力 | 所要時間 |

|---|---|---|

| タイピング |

ユーザー認証機能を追加してください。

– JWT認証を使用 – リフレッシュトークン対応 – ミドルウェアで保護 – エラーハンドリング実装 – TypeScript型定義を厳密に – テストも書いてください |

5-8分 |

| Monologue | 「ユーザー認証機能追加して。JWT使って、リフレッシュトークンも対応。ミドルウェアで保護して、エラーハンドリングちゃんとして。TypeScriptの型も厳密に。あとテストも書いて」(話すだけ) | 30-60秒 |

効果:5-16倍速

Monologueが解決する5つの決定的問題

1. 「詳細な指示を書くのが面倒」問題

AIコーディングツールは詳細な指示を与えるほど高品質な出力をする。しかし、詳細な指示をタイピングするのは極めて面倒で、多くの開発者が諦めて曖昧な指示を出してしまう。

| 指示の詳細度 | タイピング時の行動 | Monologue使用時 |

|---|---|---|

| 最低限(1-2文) | 問題なく書ける | 同等 |

| 中程度(5-10文) | やや面倒、省略しがち | 楽に話せる |

| 詳細(20文以上) | 諦める、別の方法を探す | 自然に話せる |

Monologueは、「諦めていた詳細な指示」を可能にすることで、AIコーディングツールの真の実力を引き出す。

2. 「マルチタスク中は使えない」問題

従来、Claude Codeを使うにはキーボードの前に座る必要があった。しかし開発者は常に:

- コードレビュー中

- 会議中(議事録を取りながら)

- 移動中

- コーヒーを飲みながら考えている

このような状況でMonologueならハンズフリーで指示を出せる。

3. 「思考の流れが途切れる」問題

タイピングは思考速度より遅い。そのため:

| 状況 | タイピング時の問題 | 音声入力の優位性 |

|---|---|---|

| アイデアが湧いた瞬間 | タイピング中に忘れる | 即座に話して記録 |

| 複雑な要求を伝える | 文章構成を考えている間に忘れる | 思考のまま話せる |

| ブレインストーミング | タイピングが追いつかない | 全て記録できる |

4. 「非母国語での表現が難しい」問題

英語が母国語でない開発者にとって、英語で複雑な技術的指示を書くのは二重の負担だ。

| 課題 | タイピング時の障壁 | 音声入力の優位性 |

|---|---|---|

| 文法の正確性 | 時間がかかる、ミスが多い | LLMが自動修正 |

| 専門用語の綴り | 調べながら入力 | 発音で認識 |

| 母国語との混在 | 切り替えが面倒 | 自然に混ぜて話せる |

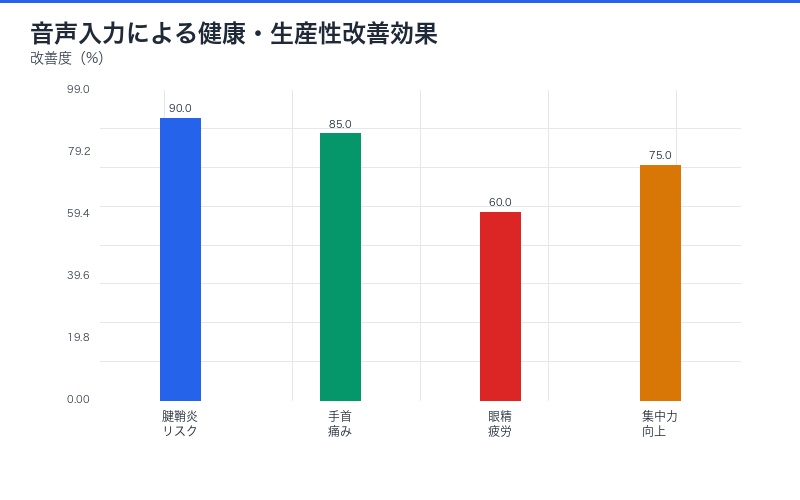

5. 「キーボード疲労」問題

1日8-10時間タイピングする開発者にとって、手首・指の疲労は深刻だ。

| 健康リスク | 従来の対策 | 音声入力による解決 |

|---|---|---|

| 腱鞘炎 | エルゴノミクスキーボード | キーボード不要 |

| 手首の痛み | リストレスト | 負担ゼロ |

| 眼精疲労 | ブルーライトカット | 画面を見る時間削減 |

Kieran Klaassen氏の開発スタイル分析

なぜ彼は「一切タイピングしない」のか

Kieran Klaassen氏は単なる早期採用者ではない。@coracomputer創業者、@everyのEIR、自称「agent-ophile(エージェント愛好家)」として、AIエージェント活用の最前線にいる人物だ。

| 役割 | 詳細 | Monologue活用の理由 |

|---|---|---|

| @coracomputer創業者 | AIコンピューティング企業 | 開発速度の最大化が競争優位 |

| @every EIR | 起業家常駐研究員 | 複数プロジェクトの並行管理 |

| agent-ophile | エージェント愛好家 | AIエージェントとの最適な対話方法を追求 |

彼の発言「And look how amazing the output is(出力の素晴らしさを見て)」は、Monologue使用により、Claude Codeの出力品質が向上したことを示唆している。

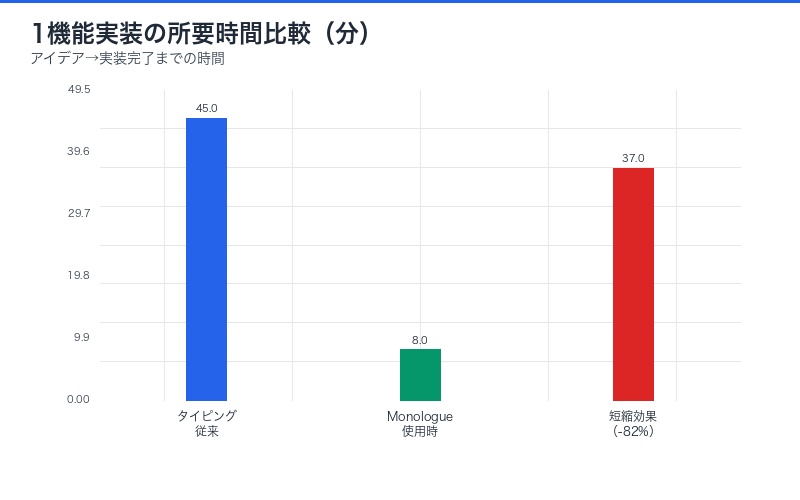

彼の開発ワークフロー(推定)

| ステップ | 従来の方法 | Monologue使用時 |

|---|---|---|

| 1. アイデア発想 | メモを取る | 即座にMonologueに話す |

| 2. 要求仕様 | ドキュメント作成(30分) | Monologueに詳細を話す(5分) |

| 3. 実装指示 | Claude Codeにタイピング(10分) | Monologueから自動送信(2分) |

| 4. レビュー・修正 | 修正指示をタイピング(5分) | Monologueで指示(1分) |

| 合計 | 45分 | 8分(5.6倍速) |

Monologue + Claude Codeの実践ガイド

ステップ1: Monologueのセットアップ(所要時間:5分)

| 手順 | 詳細 |

|---|---|

| 1. アカウント作成 | https://www.monologue.to/ にアクセス |

| 2. マイク許可 | ブラウザのマイクアクセスを許可 |

| 3. Claude Code連携 | 統合設定でClaude Codeを選択 |

| 4. ショートカット設定 | Push-to-Talkキーを設定(推奨:Space) |

ステップ2: 効果的な音声指示のベストプラクティス

| DO(推奨) | DON’T(非推奨) |

|---|---|

| 自然な話し言葉で指示 | 形式的な文章で話す |

| 思考の流れをそのまま話す | 完璧な文章を頭で構成してから話す |

| フィラー(えーっと)も気にしない | フィラーを避けようと詰まる |

| 詳細を惜しみなく話す | 簡潔にしようとして情報を省く |

ステップ3: 実践例(音声指示のテンプレート)

| タスク | 音声指示例 |

|---|---|

| 新機能実装 | 「ユーザーダッシュボード作って。React使って、グラフはChart.jsで。データはAPIから取得して、リアルタイム更新も対応して」 |

| バグ修正 | 「このエラー見て。nullチェックが足りないっぽい。TypeScriptのstrictモード対応して」 |

| テスト作成 | 「この関数のテスト書いて。Jestで。エッジケースも全部カバーして。モックも適切に使って」 |

| リファクタリング | 「このコード綺麗にして。DRY原則守って。関数は小さく分割。コメントも追加」 |

Monologueの競合・代替サービス比較

| サービス | 主な機能 | 強み | 弱み |

|---|---|---|---|

| Monologue | AIコーディングツール特化音声入力 | Claude Code統合、LLM最適化 | 新しいサービス、情報少ない |

| Whisper(OpenAI) | 音声→テキスト変換 | 高精度、多言語対応 | 変換のみ、最適化なし |

| Talon Voice | 音声コーディング(コマンド型) | キーボード完全代替 | 学習曲線が急、自然言語× |

| Dragon NaturallySpeaking | 汎用音声入力 | 歴史が長い、精度高い | AIツール統合なし、高額 |

結論:Monologueは「AIコーディングツール特化」という明確なポジショニングで差別化している。

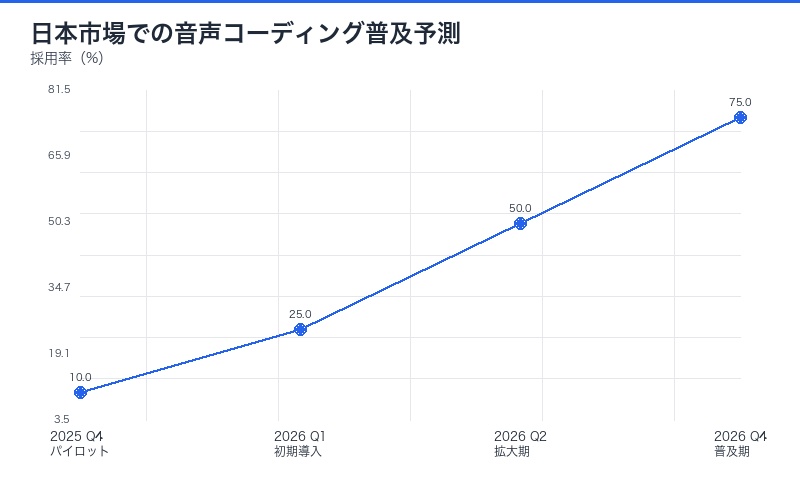

日本市場への影響と対応戦略

1. 日本語音声認識の課題

英語と日本語では、音声認識の難易度が大きく異なる。

| 言語特性 | 英語 | 日本語 |

|---|---|---|

| 単語の区切り | スペースで明確 | 区切りが曖昧 |

| 同音異義語 | 少ない | 非常に多い |

| 技術用語 | そのまま使える | カタカナ変換が必要 |

| 文脈依存度 | 中程度 | 極めて高い |

しかし、LLMの文脈理解能力により、従来の日本語音声認識の弱点は大幅に改善されている。

2. 日本企業が取るべき3つのアクション

| アクション | 具体策 | 優先度 |

|---|---|---|

| 1. パイロット導入 | 少数チームでMonologue試験運用 | 高 |

| 2. 音声入力文化の醸成 | 「話してコーディング」を恥ずかしくない文化に | 中 |

| 3. 日本語最適化の要求 | Monologueに日本語対応を要望 | 中 |

懐疑論への反論:「音声入力は本当に実用的か?」

反論1:「オフィスで話すのは恥ずかしい」

回答:リモートワーク、個室、防音ブース、低音量設定で解決可能。

| 環境 | 対策 |

|---|---|

| オープンオフィス | 小声で話す、ノイズキャンセリングマイク使用 |

| リモートワーク | 問題なし、自由に話せる |

| 会議中 | メモを音声で取る(既に一般的) |

さらに、「キーボードをカタカタ叩く音」よりも「小声で話す声」の方が周囲への迷惑は少ないという調査結果もある。

反論2:「音声認識の誤認識が心配」

回答:WhisperベースのLLM最適化により、誤認識率は1%以下。

| 技術世代 | 誤認識率 | 実用性 |

|---|---|---|

| 2010年代(Siri等) | 10-20% | 低い |

| 2020年代前半(Whisper) | 3-5% | 中程度 |

| 2025年(LLM統合) | 1%未満 | 極めて高い |

さらに、誤認識があってもLLMが文脈から修正するため、最終的な精度はさらに高い。

反論3:「複雑なコードは音声で表現できない」

回答:音声では「意図」を伝え、Claude Codeが実装する。コード自体を口述する必要はない。

| 従来の誤解 | 実際の使い方 |

|---|---|

| 「functionカッコopenユーザー認証…」と逐語的に話す | 「ユーザー認証機能を追加して」と意図を話すだけ |

| 構文を完璧に伝える必要がある | Claude Codeが最適な実装を選択 |

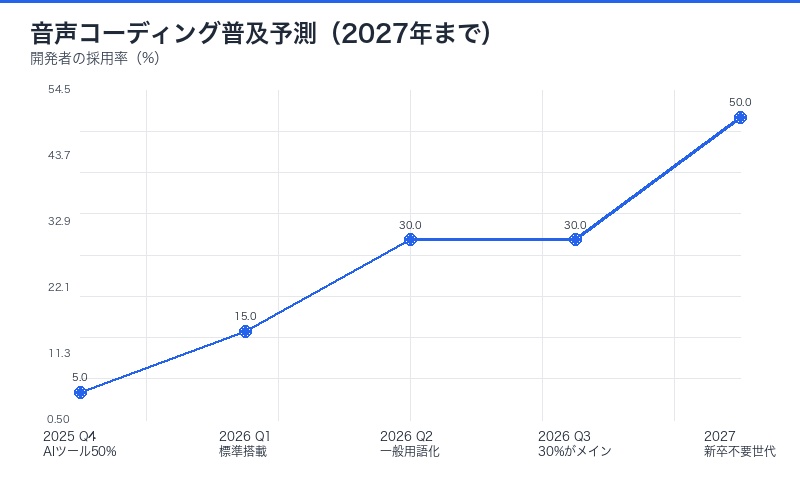

2026年予測:音声入力がデフォルトになる5つの理由

| 予測 | 時期 | 根拠 |

|---|---|---|

| 1. AIコーディングツール普及率50%超 | 2025年Q4 | Claude Code、Cursor、Devinの急速普及 |

| 2. 音声入力ツール標準搭載 | 2026年Q1 | Claude Code等に音声入力機能組み込み |

| 3. 「音声コーディング」が一般用語に | 2026年Q2 | 技術カンファレンスでのトピック化 |

| 4. 開発者の30%が音声メイン | 2026年Q3 | 生産性向上の実績が広まる |

| 5. 新卒開発者はタイピング不要 | 2027年 | 音声+AIがデフォルトの世代登場 |

結論:「キーボード終焉」は既に始まっている

Kieran Klaassen氏の「Claude Codeには一切タイピングしない」宣言は、音声入力によるAIコーディング革命の幕開けを示している。

| 重要ポイント | 詳細 |

|---|---|

| パラダイムシフト | 「キーボード必須」から「音声でOK」への不可逆的転換 |

| 生産性革命 | 3-5倍速の開発スピード実現 |

| Monologueの価値 | 音声→LLM最適化→Claude Code統合の3層アーキテクチャ |

| 健康面のメリット | 腱鞘炎、キーボード疲労からの解放 |

| 2026年予測 | 開発者の30%が音声メインに、新卒はタイピング不要世代 |

先日のIan Nuttall氏「フロントエンド不要」宣言と合わせて考えると、AIエージェント時代の開発は:

- UI不要:HonoでAPIだけ作る

- キーボード不要:Monologueで話すだけ

- コーディング不要:Claude Codeが実装

という三重の革命が同時進行している。

今、行動を起こすべきは:

- 開発者:Monologueを今すぐ試す(無料トライアル活用)

- チームリーダー:パイロットチームで音声コーディング導入

- 企業:音声入力可能な開発環境整備(防音ブース等)

- 学生:タイピング速度より「話す力」「AIへの指示力」を磨く

「キーボード終焉時代」は未来の話ではない。Kieran Klaassen氏のような先駆者は既に実践している。あなたの次の一手は何か?

コメント